是什么推动 AI 走向边缘

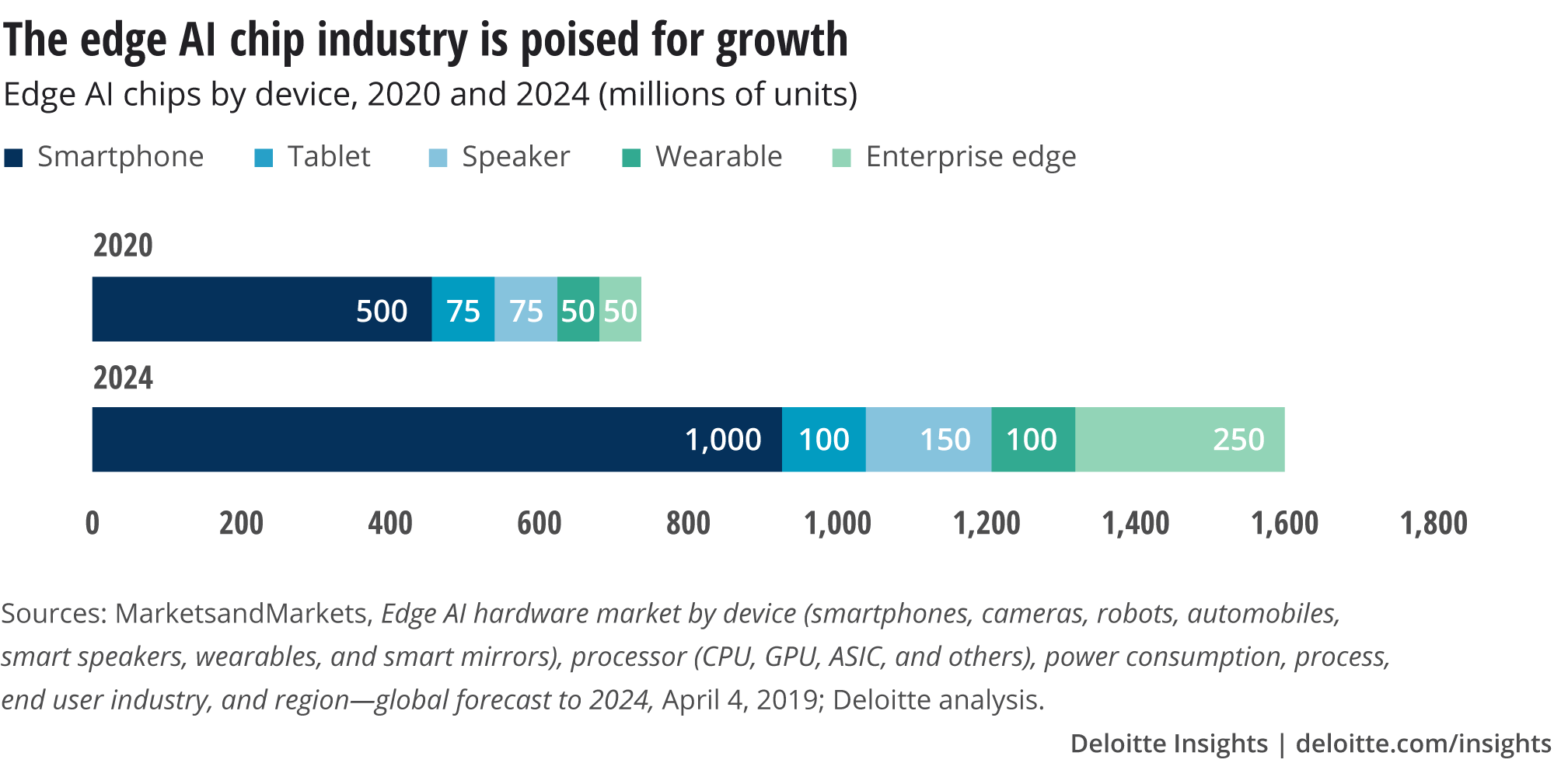

到 2020 年,我们预计将售出超过 7.5 亿个边缘 AI 芯片——在设备上而非远程数据中心执行或加速机器学习任务的芯片或芯片部分——将售出超过 26 亿美元的收入。此外,边缘人工智能芯片市场的增长速度将远高于整体芯片市场。到 2024 年,我们预计边缘 AI 芯片的销售额将超过 15 亿,可能会很大。这意味着单位销售额的年增长率至少为 20%,是整个半导体行业 9% 复合年增长率的长期预测的两倍多。

这些边缘 AI 芯片可能会进入越来越多的消费设备,例如高端智能手机、平板电脑、智能扬声器和可穿戴设备。它们还将用于多个企业市场:机器人、相机、传感器和其他 IoT(物联网)设备。

消费级边缘 AI 芯片市场比企业级市场大得多,但可能增长更慢,预计 2020 年至 2024 年的复合年增长率为 18%。企业级边缘人工智能芯片市场增长更快,预计复合年增长率50% 在同一时间范围内。

尽管如此,目前,在 2020 年,消费设备市场可能会占边缘 AI 芯片市场的 90% 以上,无论是销售数量还是美元价值。这些边缘 AI 芯片绝大多数将用于高端智能手机,占目前使用的所有消费级边缘 AI 芯片的 70% 以上。因此,在 2020 年和未来几年,人工智能芯片的增长将主要由智能手机驱动。我们认为,2020 年 15.6 亿部智能手机市场中,超过三分之一可能拥有边缘 AI 芯片。

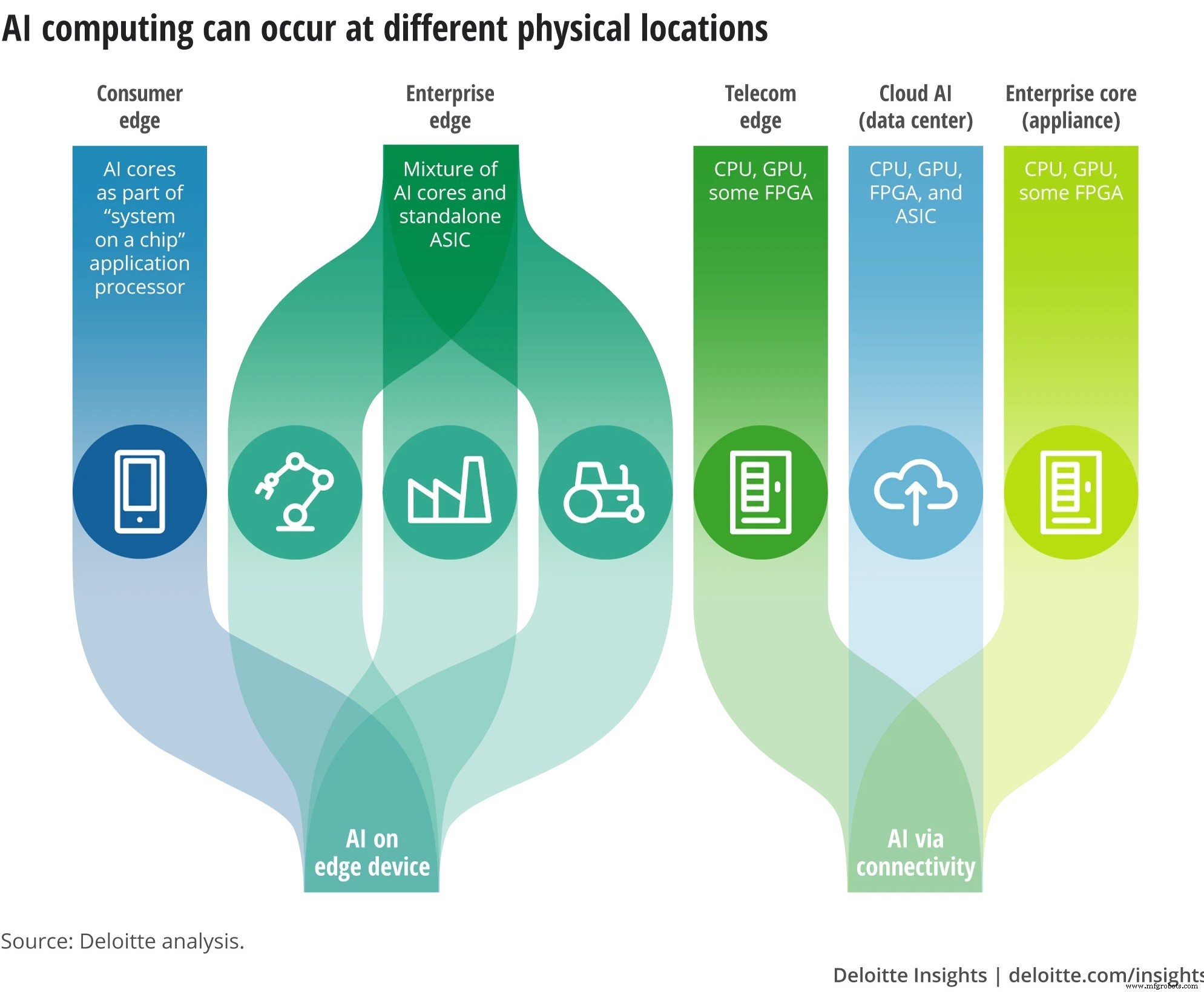

由于对处理器的要求极高,人工智能计算几乎都在数据中心、企业核心设备或电信边缘处理器上远程执行,而不是在本地设备上执行。边缘 AI 芯片正在改变这一切。它们体积更小、价格相对便宜、耗电量更少、产生的热量更少,因此可以将它们集成到手持设备以及机器人等非消费设备中。通过使这些设备能够在本地执行处理器密集型 AI 计算,边缘 AI 芯片减少或消除了将大量数据发送到远程位置的需要,从而在可用性、速度以及数据安全和隐私方面带来好处。

保持在设备上的处理在隐私和安全方面更好;永远不会离开手机的个人信息不会被拦截或滥用。当边缘 AI 芯片在手机上时,即使没有连接到网络,它也可以做所有这些事情。

当然,并非所有 AI 计算都必须在本地进行。对于某些应用程序,发送由远程 AI 阵列处理的数据可能就足够了,甚至是首选——例如,当设备的边缘 AI 芯片无法处理太多数据时。事实上,大多数时候,人工智能将以混合方式完成:一部分在设备上,一部分在云中。任何给定情况下的首选组合将根据需要完成的 AI 处理类型而有所不同。

图 1:可以嵌入情报的位置(图片:Deloitte Insights)

智能手机边缘人工智能的经济学

智能手机并不是唯一使用边缘 AI 芯片的设备;其他设备类别——平板电脑、可穿戴设备、智能扬声器——也包含它们。短期内,这些非智能手机设备对边缘 AI 芯片销售的影响可能比智能手机小得多,要么是因为市场没有增长(如平板电脑),要么是因为市场太小而无法产生实质性差异(例如,预计 2020 年智能音箱和可穿戴设备的总销量仅为 1.25 亿台)。但很多可穿戴设备和智能音箱都依赖边缘AI芯片,渗透率已经很高。

图 2:边缘 AI 芯片市场(图片:Deloitte Insights)

目前,只有最昂贵的智能手机——价格分布前三分之一的智能手机——可能会使用边缘 AI 芯片。将 AI 芯片放入智能手机中,对于消费者而言,其价格不必太高。

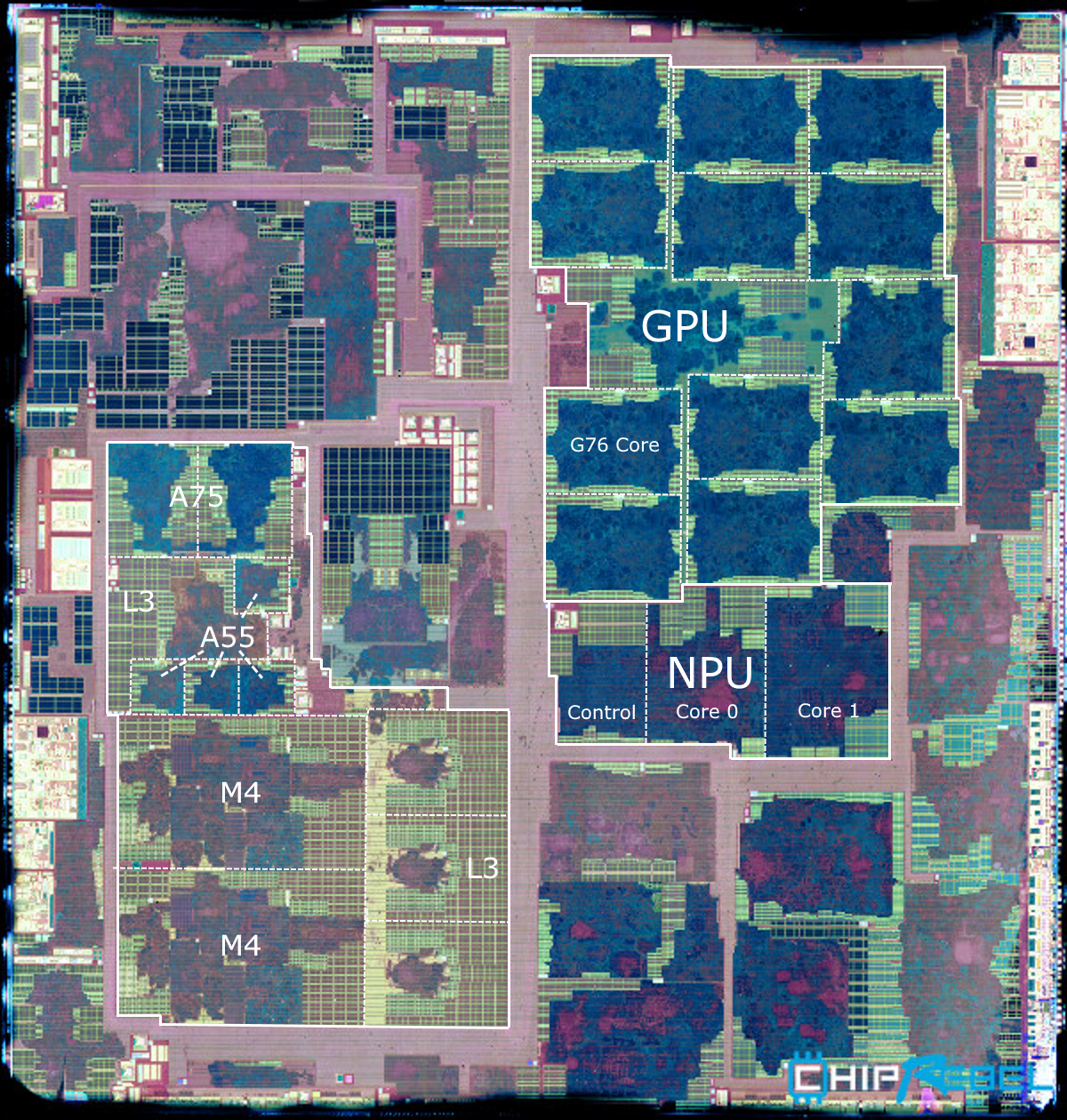

可以对智能手机的边缘 AI 芯片做出相当合理的估计。迄今为止,三星、苹果和华为手机处理器的图像显示了裸硅芯片,其所有功能都可见,从而可以识别芯片的哪些部分用于哪些功能。三星 Exynos 9820 芯片的裸片显示,大约 5% 的芯片总面积专用于 AI 处理器。三星整个 SoC 应用处理器的成本估计为 70.50 美元,这是手机第二贵的组件(仅次于显示屏),约占设备总物料清单的 17%。假设 AI 部分的成本与其他组件的芯片面积相同,Exynos 的边缘 AI 神经处理单元 (NPU) 约占芯片总成本的 5%。这相当于每人约 3.50 美元。

图 3:三星 Exynos 9820 芯片的裸片显示,大约 5% 的芯片总面积专用于 AI 处理器。 (图片:ChipRebel,注释:AnandTech)

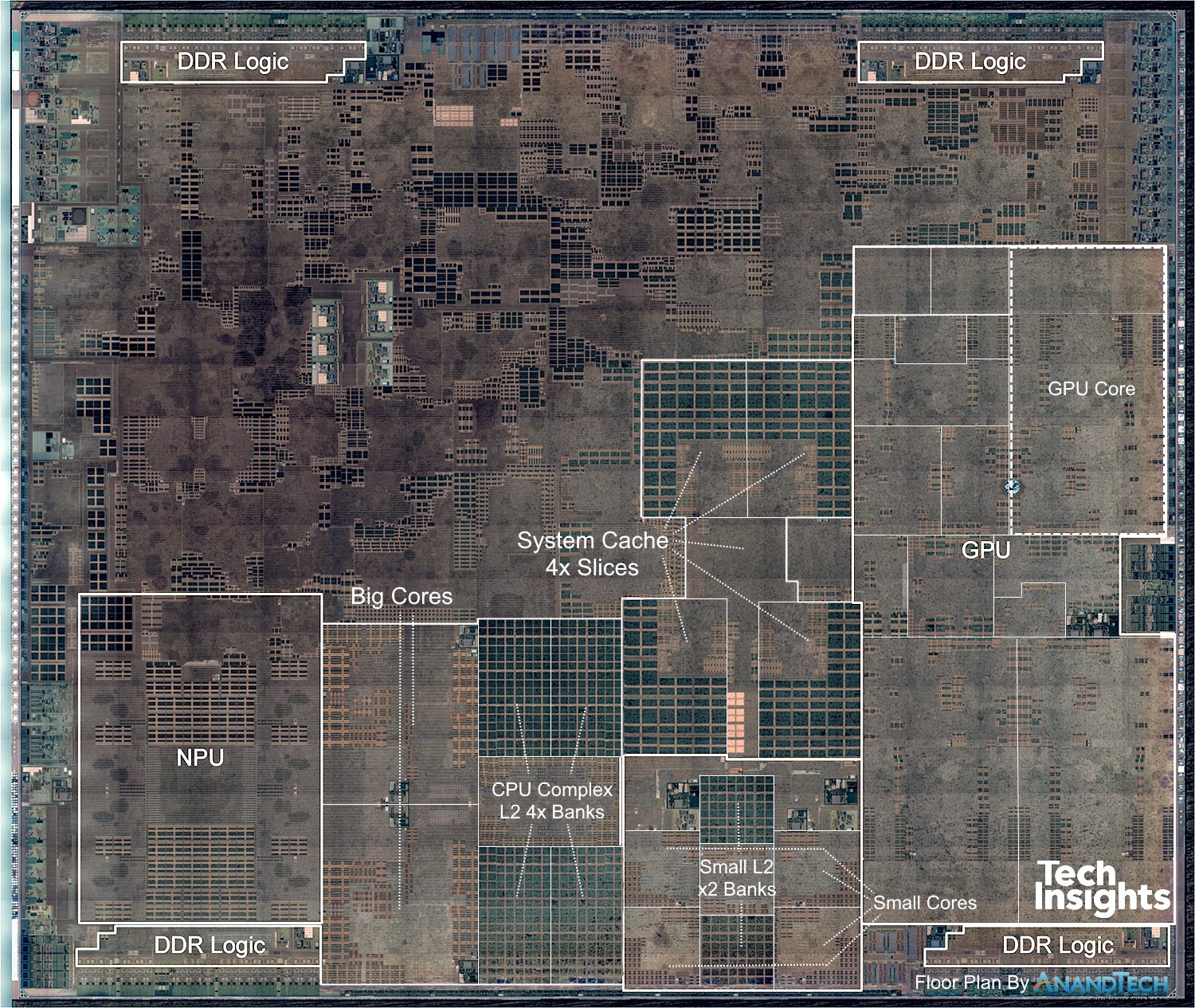

同样,Apple 的 A12 仿生芯片将大约 7% 的芯片面积用于机器学习。整个处理器估计为 72 美元,这意味着边缘 AI 部分的成本为 5.10 美元。华为麒麟 970 芯片,估计制造商成本为 52.50 美元,将 2.1% 的芯片用于 NPU,表明成本为 1.10 美元。 (不过,芯片面积并不是衡量芯片总成本中有多少百分比用于人工智能的唯一方法。根据华为的说法,麒麟 970 的 NPU 有 1.5 亿个晶体管,占芯片总数 55 亿个晶体管的 2.7%。这将建议 NPU 成本略高,为 1.42 美元)。

图 4:Apple 的 A12 仿生芯片将大约 7% 的芯片面积用于机器学习。 (图片:TechInsights / AnandTech)

虽然这个成本范围很广,但假设 NPU 平均每个芯片的成本为 3.50 美元可能是合理的。乘以 50 亿部智能手机(更不用说平板电脑、扬声器和可穿戴设备),尽管每个芯片的价格很低,但市场仍然很大。更重要的是,制造商的平均成本为 3.50 美元,最低可能为 1 美元,为智能手机处理芯片添加专用的边缘 AI NPU 开始看起来很容易。假设正常加价,制造成本增加 1 美元对最终客户来说仅意味着 2 美元。这意味着 NPU 及其随之而来的好处——更好的摄像头、离线语音辅助等——甚至可以以不到 1% 的价格增长投入到 250 美元的智能手机中。

采购 AI 芯片:内部还是第三方?

制造智能手机和其他设备类型的公司采用不同的方法来获取边缘 AI 芯片,其决策由手机型号和(有时)地理位置等因素驱动。有些人从专门制造和销售给手机制造商的第三方公司购买应用处理器/调制解调器芯片,但不制造自己的手机。高通和联发科是两个突出的例子; 2018 年,这两家公司合计占据了智能手机 SoC 芯片市场约 60% 的份额。

高通和联发科都提供各种价格的 SoC;虽然并非所有产品都包含边缘 AI 芯片,但高端产品(包括高通的 Snapdragon 845 和 855 以及联发科的 Helio P60)通常会这样做。在规模的另一端,Apple 根本不使用外部 AP 芯片:它设计和使用自己的 SoC 处理器,例如 A11、A12 和 A13 仿生芯片,所有这些都具有边缘 AI。

其他设备制造商,例如三星和华为,则采用混合策略,从商用市场芯片供应商那里购买一些 SoC,其余部分使用自己的芯片(例如三星的 Exynos 9820 和华为的麒麟 970/980)。

超过 50 家 AI 加速器公司争夺企业和工业领域的边缘 AI

如果智能手机和其他设备中使用的边缘 AI 处理器如此出色,为什么不将它们也用于企业应用程序呢?事实上,这已经发生在一些用例中,例如一些自主无人机。搭载智能手机SoC应用处理器的无人机,无需网络连接即可实时导航避障,完全在设备端。

然而,针对智能手机或平板电脑优化的芯片并不是许多企业或工业应用的正确选择。如前所述,智能手机 SoC 的边缘 AI 部分仅占总面积的 5% 左右,占总成本的 3.50 美元左右,并且比整个 SoC 的功耗低 95%。如果有人制造了一个只有的芯片会怎样 成本更低、耗电更少、体积更小的边缘 AI 部分(以及其他一些必需的功能,如内存)?

嗯,他们有。据说总共有多达 50 家不同的公司正在开发各种类型的 AI 加速器。 2019 年推出的独立边缘 AI 芯片针对的是开发人员,他们会以每个 80 美元左右的价格一次购买一个。以数千或数百万的数量购买这些芯片可能会使设备制造商的购买成本低得多:有些低至 1 美元(甚至可能更低),有些则高达数十美元。我们目前假设平均成本约为 3.50 美元,使用智能手机边缘 AI 芯片作为代理。

除了相对便宜之外,独立的边缘 AI 处理器还具有体积小的优势。它们的功率也相对较低,功耗在 1 到 10 瓦之间。相比之下,一个由 16 个 GPU 和两个 CPU 组成的数据中心集群(尽管非常强大)的成本为 400,000 美元,重 350 磅,功耗为 10,000 瓦。

有了这些芯片,边缘人工智能可以为企业开辟许多新的可能性,特别是在物联网应用方面。使用边缘 AI 芯片,公司可以大大提高分析(而不仅仅是收集)来自连接设备的数据并将分析转化为行动的能力,同时避免将大量数据发送到云中的成本、复杂性和安全挑战。 AI 芯片可以帮助解决的问题包括:

数据安全和隐私。 即使公司对数据保护保持警惕,收集、存储和移动数据到云中也不可避免地使组织面临网络安全和隐私威胁。随着时间的推移,解决这一极其重要的风险变得越来越重要。各个司法管辖区都在制定有关个人身份信息的法规,消费者对企业收集的数据越来越了解,其中 80% 的人表示,他们认为公司没有尽其所能保护消费者隐私。一些设备(例如智能扬声器)开始用于医院等对患者隐私进行更严格监管的环境。

通过允许在本地处理大量数据,边缘 AI 芯片可以降低个人或企业数据被拦截或滥用的风险。例如,具有机器学习处理功能的安全摄像头可以通过分析视频来确定视频的哪些片段是相关的,然后仅将这些片段发送到云端,从而降低隐私风险。机器学习芯片还可以识别更广泛的语音命令,因此需要在云端分析的音频更少。更准确的语音识别可以提供额外的好处,帮助智能扬声器更准确地检测“唤醒词”,防止它听到无关的对话。

低连接性。 必须连接设备才能在云中处理数据。然而,在某些情况下,连接设备是不切实际的。以无人机为例。与无人机保持连接可能很困难,具体取决于它们的运行位置,连接本身和将数据上传到云端都会缩短电池寿命。在澳大利亚新南威尔士州,带有嵌入式机器学习的无人机在海滩巡逻,以确保游泳者的安全。他们可以在没有互联网连接的情况下识别被激流带走的游泳者,或者在攻击前警告游泳者注意鲨鱼和鳄鱼。

(太)大数据。 物联网设备可以生成大量数据。例如,一架空客 A-350 喷气式飞机有 6,000 多个传感器,每天飞行产生 2.5 TB 的数据。在全球范围内,安全摄像头每天产生大约 2,500 PB 的数据。将所有这些数据发送到云端进行存储和分析既昂贵又复杂。将机器学习处理器放在端点上,无论是传感器还是摄像头,都可以解决这个问题。例如,相机可以配备视觉处理单元 (VPU)、低功耗 SoC 处理器,专门用于分析或预处理数字图像。嵌入边缘人工智能芯片,设备可以实时分析数据,只传输与云中进一步分析相关的数据,“忘记”其余部分,降低存储和带宽成本。

功率限制。 低功耗机器学习芯片甚至可以让带有小电池的设备执行 AI 计算而不会过度耗电。例如,Arm 芯片被嵌入呼吸吸入器中以分析数据,例如吸入肺活量和药物进入肺部的流量。对吸入器进行人工智能分析,然后将结果发送到智能手机应用程序,帮助医疗保健专业人员为哮喘患者开发个性化护理。除了目前可用的低功耗边缘 AI NPU,公司还在努力开发“微型机器学习”:在微控制器单元这样小的设备上进行深度学习。例如,谷歌正在开发一个 TensorFlow Lite 版本,它可以让微控制器分析数据,将需要发送到芯片外的内容压缩成几个字节。

低延迟要求。 无论是通过有线网络还是无线网络,在远程数据中心执行 AI 计算意味着在最好的情况下至少需要 1-2 毫秒的往返延迟,在最坏的情况下需要数十甚至数百毫秒。使用边缘 AI 芯片在设备上执行 AI 会将其减少到几纳秒——这对于设备必须几乎即时收集、处理和处理数据的用途至关重要。例如,自动驾驶汽车必须从计算机视觉系统以及控制车辆功能的传感器收集和处理大量数据以识别物体。然后他们必须立即将这些数据转换为决策——何时转弯、刹车或加速——以便安全操作。为此,自动驾驶汽车必须处理它们在车辆本身中收集的大部分数据。低延迟对机器人来说也很重要,随着机器人从工厂环境中脱颖而出,与人一起工作,低延迟会变得更加重要。

底线:边缘人工智能对于数据密集型应用至关重要

边缘 AI 芯片的普及可能会为消费者和企业带来重大变化。对于消费者而言,边缘 AI 芯片可以实现多种功能——从解锁手机,到与语音助手对话,再到在极端困难的条件下拍摄令人兴奋的照片,而且无需互联网连接。

但从长远来看,边缘 AI 芯片更大的影响可能来自它们在企业中的使用,它们可以使企业将其物联网应用提升到一个全新的水平。由人工智能芯片驱动的智能机器可以帮助扩大现有市场,威胁现有企业,并改变制造、建筑、物流、农业和能源等行业的利润分配方式。收集、解释大量数据并立即对大量数据采取行动的能力对于未来学家认为将变得广泛的许多数据密集型应用至关重要:视频监控、虚拟现实、自主无人机和车辆等。未来在很大程度上取决于边缘 AI 芯片能够实现的功能:为设备带来智能。

Duncan Stewart 和 Jeff Loucks 就职于德勤技术、媒体和电信中心。本文基于德勤为其 TMT Predictions 2020 报告最初发表的一篇文章。

嵌入式