AI 的固有局限性需要“提前”安全意识

作为一名前大功率电子工程师,我为从早期原型 CAT 扫描系统到粒子加速器的各种应用设计并测试了高压电源。我对高功率微波系统做了同样的事情,从模拟器到测试雷达对敏感飞机电子设备的影响,从一个极端到另一个处理格兰诺拉麦片。 30多年来,我处理了几十千伏的直流电压和几十千瓦的微波功率。

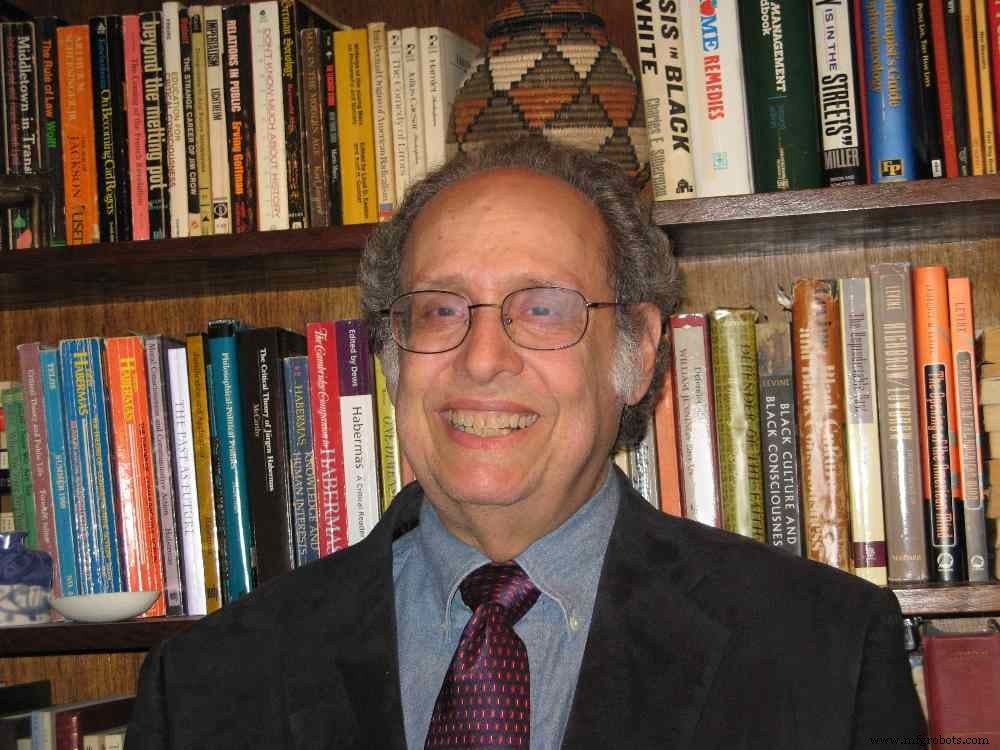

Ed 的博客

SAE Media Group 的 Ed Brown 经过数十年的 EE 工作,已经进入了他的第二个职业:技术编辑。

“我意识到,回顾我的工程时代,并作为一名编辑观看了所有最新和最伟大的作品,鉴于我的工程经验,我对现在正在发生的事情有很多想法,现在我想分享其中的一些。” .

一切都必须设计为具有尽可能大的安全裕度,并以故障安全为目标。这意味着提前考虑系统可能发生故障的可能方式,并设计以最大限度地减少故障造成伤害或损坏的可能性。例如,我们使用了电子“撬棒”,如果传感器发出负载电流突然增加的信号,它会在几微秒内安全地短路输出。但那是一个有源系统,在电源故障的情况下将无法工作。因此,我们使用了由电磁铁支撑的备用机械撬棒作为故障安全保护。如果输入线路电源出现故障,则金属棒会从输出端掉落。这一点很重要,因为即使没有电源,电容器组中也可能存储危险的能量——当我从一个我认为安全关闭的电源受到电击时,我曾经为自己惊恐地发现了这一点。

正是带着这种心态,我想到了人工智能 (AI)。我不担心人工智能会取代人类智能,把我们都变成机器人。但我确实担心过度依赖它,尤其是在至少两个领域:高级驾驶辅助系统 (ADAS) 中的安全应用以及自动驾驶汽车和疾病诊断。

因此,当我读到 AI 中的“固有限制”时,它引起了我的注意 .来自剑桥大学和奥斯陆大学的研究人员断言,处理 AI 的神经网络在某些条件下可能不稳定,并且无法通过简单地添加更多训练数据来解决这种不确定性。根据研究人员的说法,我们需要更多的理论工作来更好地理解人工智能计算的数学。要获得更可靠的结果,您必须了解特定的错误来源并更改 AI 方法来修复它。

加州大学伯克利分校和德克萨斯大学奥斯汀分校的研究人员注意到一个问题 当他们未能复制医学成像研究的有希望的结果时。 “经过几个月的工作,我们意识到论文中使用的图像数据已经过预处理,”研究首席研究员、加州大学伯克利分校电气工程和计算机科学教授 Michael Lustig 说。

这就是麻烦的根源。 “我们希望提高对这个问题的认识,以便研究人员可以更加小心并发布更现实的结果,”Lustig 说。

他们发现不准确是由于使用有偏见的公共数据库来训练系统造成的。研究人员创造了“隐性数据犯罪”一词来描述使用错误方法开发算法时产生的研究结果。

在与 SAE 数字编辑经理 Billy Hurley 的问答中,来自慕尼黑工业大学 (TUM) 的 Eckehard Steinbach 教授描述了 AI 模型“可能无法识别或尚未发现”的潜在关键汽车情况。例如,重复制动的模式可能是在温暖的天气中定期驾驶,但如果道路结冰和湿滑,则可能表明即将脱离接触。这种模式很难识别。

但从好的方面来说,Steinbach 的团队开发了安全技术,可以从自己以前的错误中内省学习。 “如果汽车进入未经训练的情况,就会出现问题,”斯坦巴赫说。 “这种新颖的场景会引起人为干预,从而导致这些场景被用作我们方法的训练数据。虽然我们的方法可以帮助在下次遇到这种新的具有挑战性的环境时检测它,检测并正确管理一个全新的场景第一次遇到它仍然是一项具有挑战性的任务。”

我从这一切中得出的结论是,人工智能可以加快和改善医疗诊断。它还有助于使车辆在道路上更加安全。但是你必须注意你的方法。

在设计 AI 系统时,像高压工程师一样思考至关重要:提前考虑系统可能出现故障的可能方式,并以尽量减少发生这种情况的机会为目标进行设计。如果确实发生故障,则旨在减少受伤或损坏的机会。

你同意吗?在下方分享您的问题和意见。

阅读 Ed 博客中的更多内容:由外而内设计与由内而外设计

传感器