将 AI 模型压缩到微控制器中

当您将人工智能与物联网交叉时,您会得到什么?物联网 (AIoT) 是一个简单的答案,但您也获得了微控制器的巨大新应用领域,这得益于神经网络技术的进步,这意味着机器学习不再局限于超级计算机领域。如今,智能手机应用处理器可以(并且确实)为图像处理、推荐引擎和其他复杂功能执行 AI 推理。

将这种能力带入不起眼的微控制器代表了一个巨大的机会。想象一下可以使用 AI 过滤对话中的背景噪音的助听器、可以识别用户面部并切换到其个性化设置的智能家电,以及可以使用最小电池运行数年的支持 AI 的传感器节点。在端点处理数据具有不可忽视的延迟、安全和隐私优势。

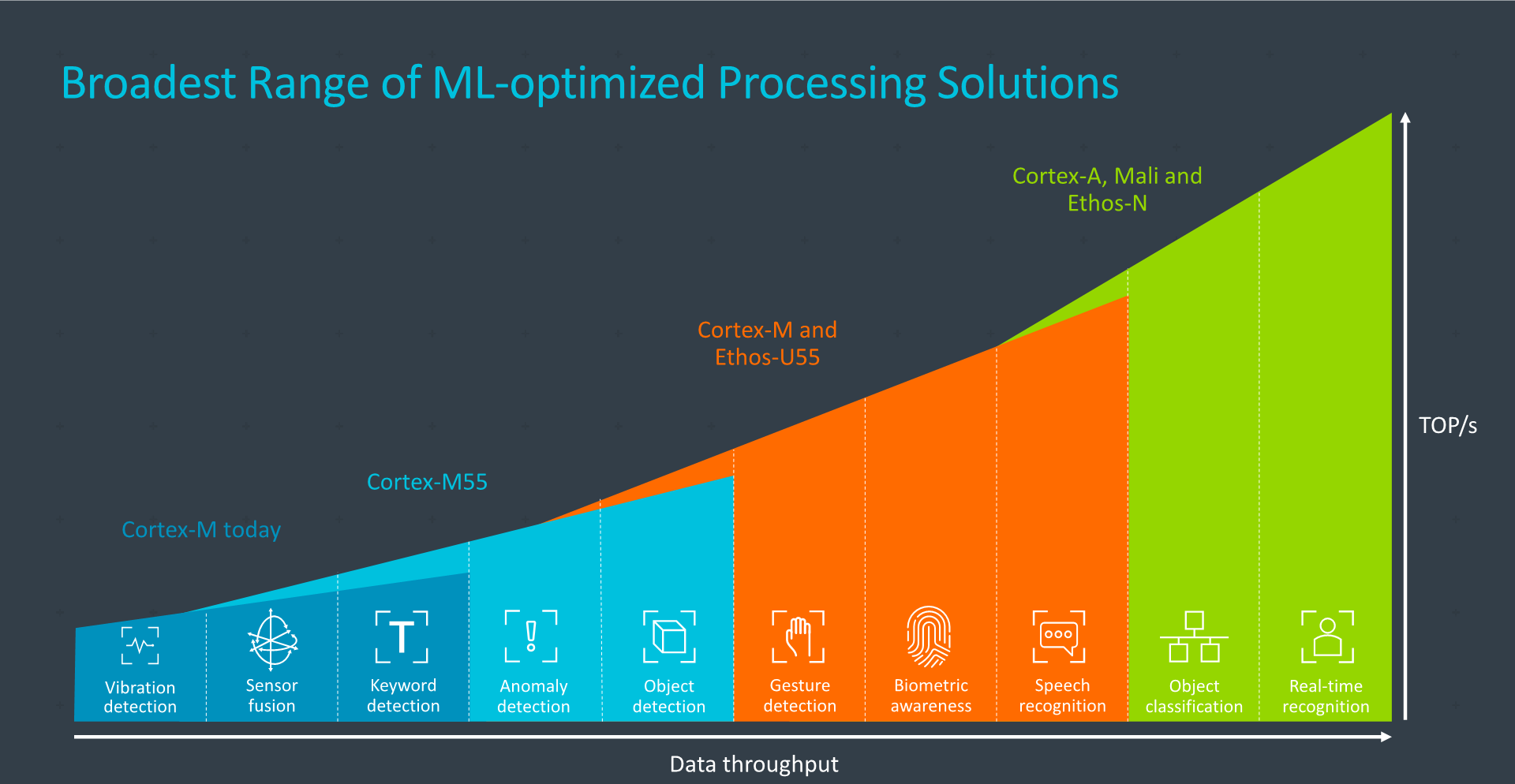

Arm 的 Cortex-M55 和 Ethos-U55 协同使用,具有足够的处理能力,适用于手势识别、生物识别和语音识别等应用(图片:手臂)

然而,使用微控制器级设备实现有意义的机器学习并非易事。例如,作为 AI 计算的关键标准的内存通常受到严重限制。但数据科学正在迅速发展以缩小模型尺寸,设备和 IP 供应商正在通过开发工具和整合为现代机器学习的需求量身定制的功能做出回应。

TinyML 起飞

作为该行业快速增长的标志,2 月份在硅谷举办的新行业盛会 TinyML 峰会正在不断壮大。去年举办的第一届峰会有11家赞助公司;据组织者称,今年的活动有 27 个,而且插槽售罄的时间要早得多。组织者表示,参加 TinyML 全球设计师月度聚会的人数急剧增加。

TinyML 委员会联合主席、Qualcomm 高级总监 Evgeni Gousev 表示:“我们看到了一个由 TinyML 技术支持的数万亿智能设备的新世界,这些设备可以感知、分析并自主行动,为所有人创造一个更健康、更可持续的环境。 ,在他最近的一次会议上的开幕词中。

Gousev 将这种增长归因于更节能的硬件和算法的开发,以及更成熟的软件工具。他指出,企业和风险投资正在增加,初创公司和并购活动也在增加。

今天,TinyML 委员会认为该技术已经过验证,并且在微控制器中使用机器学习的初始产品应该会在两到三年内上市。人们认为“杀手级应用”还需要三到五年的时间。

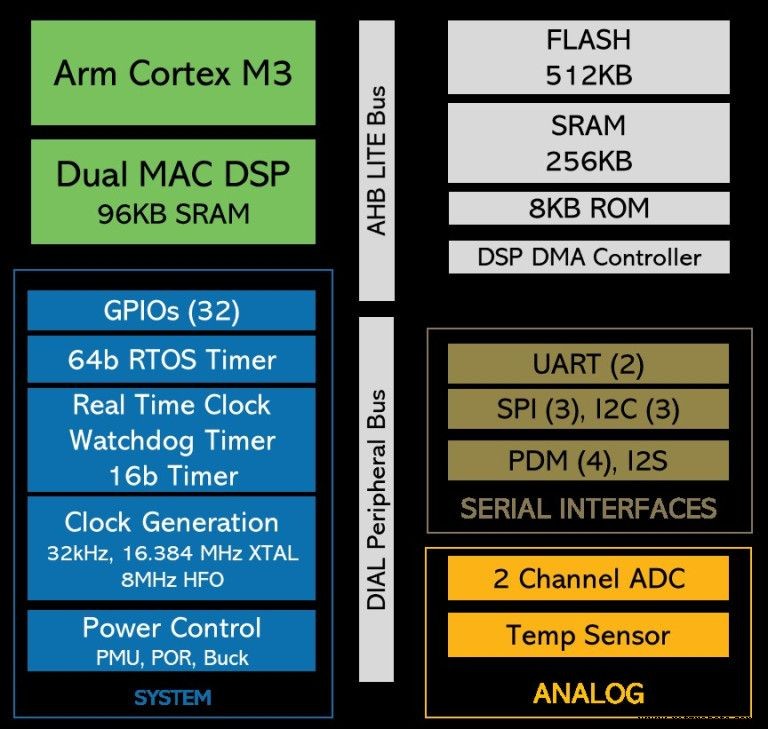

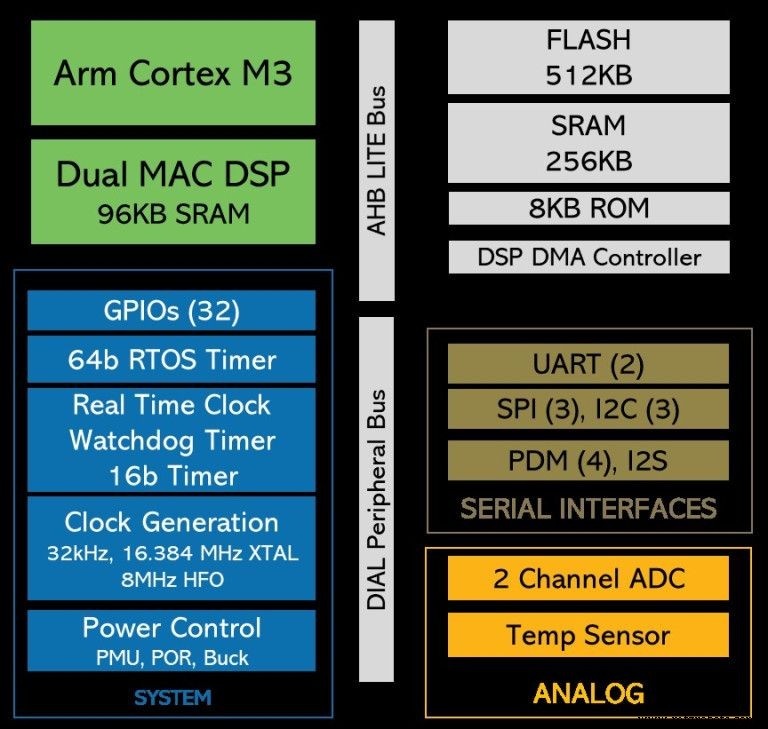

去年春天,当谷歌首次展示了其用于微控制器的 TensorFlow 框架版本时,技术验证的很大一部分是在去年春天进行的。 TensorFlow Lite for Microcontrollers 旨在在只有 KB 内存的设备上运行(核心运行时在 Arm Cortex-M3 上的容量为 16 KB;如果有足够的运算符来运行语音关键字检测模型,它总共需要 22 KB )。支持推理但不支持训练。

大玩家

当然,大型微控制器制造商正在饶有兴趣地关注 TinyML 社区的发展。随着研究使神经网络模型变得更小,机会变得更大。大多数都对机器学习应用程序提供某种支持。例如,意法半导体有一个扩展包 STM32Cube.AI,可以在其基于 Arm Cortex-M 的 STM32 系列微控制器上映射和运行神经网络。

瑞萨电子的 e-AI 开发环境允许在微控制器上实施 AI 推理。有效地将模型转化为公司e2工作室可用的形式,兼容C/C++项目。

恩智浦半导体表示,有客户将其低端 Kinetis 和 LPC MCU 用于机器学习应用。该公司正在通过硬件和软件解决方案拥抱人工智能,尽管主要面向其更大的应用处理器和跨界处理器(应用处理器和微控制器之间)。

强力武装

微控制器领域的大多数老牌公司都有一个共同点:Arm。这家嵌入式处理器核心巨头凭借其 Cortex-M 系列主导了微控制器市场。该公司最近发布了全新的 Cortex-M55 内核,该内核专为机器学习应用而设计,尤其是与 Arm 的 Ethos-U55 AI 加速器结合使用时。两者都是为资源受限的环境而设计的。但初创公司和小公司如何才能在这个市场上与大公司竞争?

“不是通过构建基于 Arm 的 SoC,因为[占主导地位的玩家] 做得非常好,”XMOS 首席执行官 Mark Lippett 笑着说。 “与这些家伙竞争的唯一方法是拥有架构优势...... [这意味着] Xcore 在性能方面的内在能力,以及灵活性。”

XMOS 的 Xcore.ai 是其新发布的用于语音接口的跨界处理器,不会直接与微控制器竞争,但这种观点仍然成立。任何制造基于 Arm 的 SoC 以与大公司竞争的公司最好都有一些非常特别的秘诀。

>> 继续阅读第二页文章最初发表在我们的姊妹网站 EE Times Europe。

嵌入式